Ein Rückblick auf zwei Jahre FDMLab

Bild erstellt aus einem Bild von Peggy_Marco auf Pixabay.

Bild erstellt aus einem Bild von Peggy_Marco auf Pixabay.Nach zwei Jahren steht das FDMLab@LABW kurz vor dem Ende der ersten Projektlaufzeit. Dies nehmen wir zum Anlass, zurückzublicken und eine Zwischenbilanz zu ziehen: Was waren unsere wichtigsten Projekte? Was haben wir erreicht und was war schwierig? Was würden wir in Zukunft gerne tun?

Formung des Projektteams und Einarbeitung

Das FDMLab hat den Auftrag, am Landesarchiv Baden-Württemberg eine Basisinfrastruktur im Bereich E-Science und Forschungsdatenmanagement (FDM) aufzubauen, welche einen Beitrag zur NFDI leistet. Das zentrale Ziel ist dabei stets, die Auffindbarkeit, Zugänglichkeit und Nutzbarkeit unseres Archivguts zu erhöhen und die Nutzungsmöglichkeiten an einer zunehmend digitalen Forschungspraxis auszurichten. Dazu haben wir bereits vorhandene Konzepte und Technologien aus dem Data Science und KI-Bereich für den Einsatz im Landesarchiv evaluiert, einige geeignete Instrumente (ggf. mit Anpassungen) testweise implementiert und uns aktiv in die GLAM-Labs-Community eingebracht, um die Bedarfe der Archive zu kommunizieren und Impulse für die Weiterentwicklung relevanter Werkzeuge zu liefern.

Um diese Aufgaben anzugehen, braucht es einerseits das Verständnis archivischer Quellen und der Arbeitsprozesse rund um die Erschließung, Digitalisierung und Bereitstellung im Archiv. Andererseits sind umfangreiche Kenntnisse in den Bereichen Data Science und Maschinelles Lernen wichtig. Das Kernteam unseres Projekts besteht aus einer Archivarin und einem Data Scientist. Diese Kombination von Expertisen ist für das FDMLab ein wichtiger Erfolgsfaktor. Besonders die Anfangszeit des Projekts war geprägt von einem Kommunikationsprozess, in dessen Verlauf das Projektteam zu einer gemeinsamen Sprache fand und viel aus der Denkweise der Teammitglieder lernte. Hierbei gab es auch immer wieder wertvollen Input von zahlreichen Kolleginnen und Kollegen aus ganz unterschiedlichen Abteilungen des Landesarchivs.

Das FDMLab war von vornherein als experimentelles Forschungsprojekt geplant. Daher entschieden wir uns für ein iteratives Vorgehen. Anstatt einen starren Projektplan zu entwerfen, bearbeiteten wir verschiedene inhaltlich stark verzahnte Themenfelder parallel. Dies hatte den Vorteil, dass wir auf Erfolge und Rückschläge bei Experimenten flexibel reagieren konnten. Auch konnte das FDMLab immer wieder kurzfristig Hilfe leisten, wenn andere Projekte oder Abteilungen des Landesarchivs eine Frage zur Datenaufbereitung stellten. Dadurch konnten wir unsere Arbeitsweise und unseren Fokus auf die direkten Bedürfnisse unserer Kolleginnen und Kollegen anpassen.

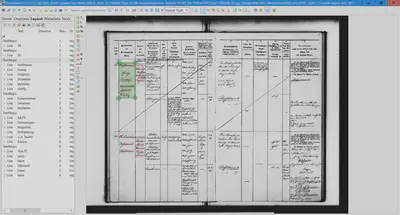

Volltextgenerierung

Die Volltexterkennung bildete einen der thematischen Schwerpunkte der vergangenen Projektlaufzeit. Das FDMLab hat verschiedene OCR- und HTR-Werkzeuge für die Erkennung von Text in digitalisiertem Archivgut getestet.1 Als Testmaterial dienten hierbei die digitalisierten Kriegs- und Friedensstammrollen aus dem Hauptstaatsarchiv Stuttgart (Bestände LABW HStA M 430/1 – M 631) und dem Generallandesarchiv Karlsruhe (Beständegruppe XIV. (Badisches) Armeekorps) und die ebenfalls digitalisierten Kriegsgräberlisten aus der Abteilung Staatsarchiv Ludwigsburg (Bestand LABW StAL EL 20/1 VI). Diese Bestände weisen einige Merkmale auf, die für einen größeren Teil des jüngeren Archivguts im Landesarchiv Baden-Württemberg charakteristisch sind: ein komplexes tabellarisches Layout, sowie eine Mischung aus Handschrift, Druckschrift und Schreibmaschinenschrift, wie in Abbildung 1 gezeigt.2

].](/post/2022-07-ein-rueckblick-auf-zwei-jahre-fdmlab/personalblatt_hua229dce7e6a679abb9314318f4089406_985121_e3e584e5cc042ae1080b49dea033a767.webp)

Anhand dieser Testbestände konnten wir wertvolle Erfahrungen mit dem Aufbau geeigneter Workflows für die Volltexterkennung sammeln. Für gedruckte Archivalien des Landesarchivs eignen sich vor allem die Werkzeuge von OCR-D und OCR4All.

Bei handschriftlichem Archivgut hat sich die Software Transkribus bewährt. Eine “One fits all”-Lösung für alle Bestände des Landesarchivs kann es dabei nicht geben, was wir bereits zu Projektbeginn auch vermutet hatten. Unser Archivgut aus verschiedenen Jahrhunderten ist sowohl im Schriftbild als auch im Layout sehr heterogen. Daher müssen für unterschiedliche Bestände jeweils eigene Workflows aufgebaut und die Parameter der Erkennungssoftware darauf angepasst werden.

Um komplexere Layouts wie das der militärischen Stammrollen zu verarbeiten, führt nach dem aktuellen Stand der Technik außerdem kein Weg daran vorbei, eigene Erkennungsmodelle zur Layouterkennung zu trainieren. Transkribus besitzt zwar auch eine eingebaute Layouterkennung. Diese kann mit Tabellen und Formularen jedoch nicht ohne Weiteres umgehen. Um ein eigenes Modell zu trainieren, muss man zunächst umfangreiche Ground Truth-Daten manuell erstellen, die dem Algorithmus der Texterkennungssoftware als “Übungsbeispiele” dienen können. Hierfür sind erhebliche Personal- und Zeitressourcen notwendig. Auch nach Abschluss eines Modelltrainings fällt weiterhin eine intellektuelle Nachbearbeitung der automatisch generierten Volltexte an, soweit das Ergebnis noch nicht den Qualitätsansprüchen genügt.

Die Bewertung von Ergebnissen einer Volltexterfassung von unserem Archivmaterial gestaltete sich zunächst aufwendiger als gedacht. Die Standardmetrik Character Error Rate (CER) berücksichtigt auch das Layout, was in den meisten Fällen auch Sinn ergibt. Im Falle von tabellarischen Inhalten, kann jedoch schon eine Abweichung der Lesart (zeilenweise vs. spaltenweise) zu sehr schlechten Bewertungen bei eigentlich guten OCR-Ergebnissen führen. In der folgenden Tabelle ist ein Beispiel mit neun Zahlen, wo nur auf Grund der unterschiedlichen Lesart eine Fehlerrate von über 66 Prozent erzeugt wird.

| 1 | 2 | 3 | - | Lesart | Reihenfolge |

|---|---|---|---|---|---|

| 4 | 5 | 6 | - | zeilenweise | 1 2 3 4 5 6 7 8 9 |

| 7 | 8 | 9 | - | spaltenweise | 1 4 7 3 5 8 3 6 9 |

Daher haben wir uns mit alternativen Metriken zur Bewertung von OCR-Ergebnissen beschäftigt und für uns die Flexible Character Accuracy entdeckt.3 Diese ist zwar weitaus aufwendiger zu berechnen, lässt sich dafür aber von Abweichungen von der Lesart eines Formates nicht so stark beeinflussen.

Als hilfreich beim Aufbau von speziellen Workflows zur OCR-Erkennung hat sich das Projekt OCR-D erwiesen, mit dem sich verschiedenste Open-Source-Anwendungen aus dem Texterkennungsbereich über eine einheitliche Schnittstelle bedienen lassen. So können zum Beispiel unterschiedliche Werkzeuge zur Layoutbestimmung und Zeichenerkennung miteinander kombiniert und mit eigenen Modulen, ergänzt werden. Als Oberfläche zur Erstellung von so genannten Ground Truth Daten haben wir uns zu Beginn unseres Projektes für OCR4All entschieden, welches in Phase III auch ein Teil des OCR-D Projektes wurde.

Neben der vollständigen Digitalisierung von analogem Material, sind wir manchmal auch an Teildigitalisierungen interessiert. Beispielsweise werden bei der Digitalisierung von Findmitteln oder Übergabelisten nicht alle analogen Inhalte in der digitalen Version benötigt. Für diesen Zweck haben wir mit dem Einsatz von Scanstiften experimentiert. Diese sind ähnlich groß wie Textmarker und können einzelne Wörter, Phrasen oder Zeilen scannen, OCR erfassen und z.B. direkt in das zugehörige Formularfeld einer Erfassungssoftware übertragen. Es benötigt etwas Eingewöhnung, bis man den richtigen Winkel und die richtige Geschwindigkeit zur Bedienung herausgefunden hat. Bei richtiger Bedienung funktionieren die Scanstifte für moderne Drucke ähnlich gut wie kommerzielle Software für die OCR-Erfassung (die unter der Haube teilweise auch eingesetzt wird). Es gibt jedoch keine direkte und für technische Laien verständliche Möglichkeit die Scanstifte für die Erfassung behördlicher Schreibmaschinenschrift, Handschriften oder historischer Drucke anzupassen.4

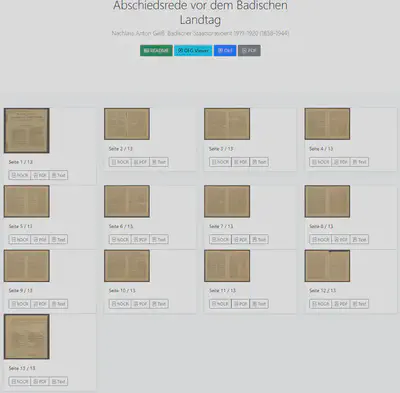

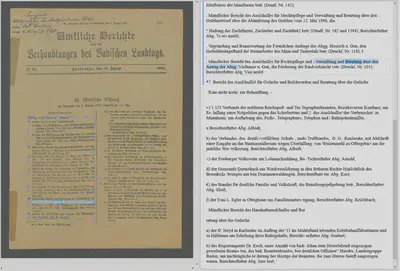

Neben der Erfassung von Volltexten beschäftigten wir uns auch mit verschiedenen Möglichkeiten der Darstellung von Volltexten in Webanwendungen. Dafür setzten wir die Anzeige von Volltexten für den Bestand Abschiedsrede von Anton Geiß, GLAK N Geiss Nr. 6 in einem Prototyp für verschiedene Möglichkeiten wie hOCR und den DFG-Viewer um und testeten die Bedienung der verschiedenen Anzeigevarianten, wobei der Fokus auf der Benutzung und nicht der Qualität des Volltextes bzw. des Designs lag (siehe Abbildungen 3 und 4).

Datenanalyse und -anreicherung

Eine Aufgabe im Archiv ist die Retrodigitalisierung, also die zur Verfügungstellung analog vorliegender Daten in digitaler Form für die wissenschaftliche Nutzung. Dies ermöglicht in der Regel nicht nur einen einfacheren Zugang zu den Daten, sondern unterstützt zusätzlich auch die Bestandserhaltung. Neben der (Retro)Digitalisierung von Archivalien gehört hier auch die Digitalisierung der entsprechenden Metadaten, also der Findmittel dazu, aber auch die Umwandlung von schon digital vorliegenden Daten in strukturierte Formate oder semantisch beschriebene Datensätze.

Eines unserer ersten Projekte im FDMLab war die Überführung des gedruckten Findbuches “Fürstlich Thurn und Taxissches Archiv Obermarchtal Grafschaft Friedberg-Scheer" in unser archivisches Fachinformationssystem (AFIS).5 Hierbei konnten wir schnell feststellen, dass vermeintlich durchstrukturierte Findbücher in vielen Punkten minimal vom vermeintlich einheitlichen Schema abweichen, sodass eine komplett automatische Einsortierung der einzelnen Textbestandteile in die entsprechenden Formularfelder nicht sinnvoll ist.

Bei unserem Folgeprojekt, der (Retro)Digitalisierung der Findbücher zu den Reichskammergerichtsakten, haben wir daher OpenRefine eingesetzt. Das hat den Vorteil, dass wir einerseits automatisch strukturierte Daten in Massenbearbeitungen aus dem Text extrahieren können, andererseits die problematischen Abweichungen schnell identifizieren und separat behandeln können.6

1 1 Nr ( C 2145 Altsignatur ) 1597 – 1600 Laufzeit

Vorsignatur: R Rep. 9 Nr. 230 VorsignaturStrukturbeispiel (Abschnitt 1) für Findbuch zu Akten des Reichskammergerichts.

OpenRefine hat uns dabei so gefallen und wir haben so positiv davon berichtet, dass wir von mehreren Kolleginnen und Kollegen gebeten wurden dazu doch einen internen OpenRefine Einsteigerworkshop anzubieten. Dieser wurde wiederum so positiv aufgenommen, dass wir den OpenRefine Einsteigerworkshop inzwischen schon viermal durchgeführt haben und darauf aufbauend einen OpenRefine Fortgeschrittenenworkshop erstellt und ebenfalls bereits zweimal durchgeführt haben. Die zugehörigen Materialien und Anleitungen haben wir zusätzlich für unseren Blog aufbereitet und dort zur Verfügung gestellt.

Die Resonanz aus dem deutschsprachigen GLAM-Bereich (Galerien, Bibliotheken (Libraries), Archive und Museen) zu OpenRefine ist bisher recht positiv und uns erreichen aus dem deutschsprachigen Raum auch immer mal wieder Anfragen zu konkreten Problemen oder Projekten, bei denen wir im Rahmen unserer Möglichkeiten gerne weiterhelfen.

Ein weiteres Daten-Projekt, welches wir im FDMLab technisch begleiten durften, ist das Themenmodul Gurs im Landeskundlichen Informationssystem Baden-Württemberg (LEO-BW). Konkret wurde hier mit OpenRefine eine von mehreren Kolleginnen und Kollegen zusammengetragene Excel-Datei inhaltlich und strukturell vereinheitlicht und für die Veröffentlichung als Datenbank im XML-Format aufbereitet. Dazu gehörte auch die Einbindung von Bildern, die Anreicherung von Orten mit Normdaten und Geokoordinaten sowie die Recherche und Normdatenerstellung in Kooperation mit Verena Mack von der GND-Agentur LEO-BW-Regional.

in LEO-BW.](/post/2022-07-ein-rueckblick-auf-zwei-jahre-fdmlab/screenshot-leo-bw-gurs-karte_hu1719a32351d11bd69bc5dc8ef81202ab_914267_995786493ec5f6e626b3833b07d4b4c3.webp)

Ähnlich wurde vom FDMLab das Projekt Winterberg-Tunnel auf LEO-BW unterstützt.7 Wobei hier der Fokus auf der Restrukturierung der Personendaten lag, damit diese auf LEO-BW als Datenbank angeboten werden können, sowie die Ergänzung und Erstellung von Normdaten für Orte wiederum in Kooperation mit Verena Mack.

Bei unserer Arbeit mit Normdaten zu Orten in Baden-Württemberg in der Gemeinsamen Normdatei (GND) stolperten wir hin und wieder über Dubletten. Gemeinsam mit Verena Mack führten wir ein Experiment mit SPARQL auf einem Apache Jena Triple Store durch, um solche Orte zu identifizieren und eine Bereinigung der Daten beauftragen zu können. Dabei konnten wir circa 600 eindeutige Dubletten bei 33.000 Ortsdatensätzen für Baden-Württemberg identifizieren. Details dazu unter unserem Bericht zum Experiment zur Identifikation von doppelten Orten in der GND.

Weitere Erfahrungen bei der Arbeit mit Normdaten konnten wir bei der Unterstützung der Aufbereitung des Bestandes StAL EL 68 IX Landesvermessungsamt Baden-Württemberg: Landesbefliegung Baden-Württemberg 1968 - Luftbilder und digitales Orthophoto sammeln. Hier wurden 21.132 Datensätze mit 19.569 digitalisierten Luftbildern und 30.000 georeferenzierten Orthofotokacheln automatisiert mit insgesamt 195.988 teils neuen, normierten Ortsdeskriptoren verknüpft. Siehe dazu auch Luftbilder aus der Sammlung des Landesvermessungsamts Baden-Württemberg online.

Auch die Überführung in neuere Datenformate gehört zu unseren Aufgaben im Archiv. Zum Beispiel liegen die Daten der Volkszählung 1961 (Bestand StAL EL 413/4) seit 2005 in Form von Textdateien im Staatsarchiv Ludwigsburg. Dort wurden sie als alternative Repräsentation in CSV mit ergänzenden XML-Metadaten gespeichert. Zur besseren Zugänglichkeit wurden die Daten im FDMLab zusätzlich in eine SQLite-Datenbank überführt, wobei eine Verknüpfung der Daten in den CSV-Dateien mit den XML-Metadaten vorgenommen wurde. Dadurch erhoffen wir uns eine bessere Nutzbarkeit durch Forschende.

Die Unterstützung bei der Aufbereitung von Metadaten für die Datenweitergabe an Portale, die Daten zu einem bestimmten Thema aggregieren, gehört ebenfalls zu den Routineaufgaben des FDMLab. Eine Anforderung solcher Portale ist häufig die Ergänzung von Geodaten, um die einzelnen Bestände auf einer Karte visualisieren zu können. Hierfür vervollständigen wir im FDMLab Bestände des Landesarchivs mit Ortsnormdaten und ergänzen die Metadaten für die Weitergabe mit für das Zielsystem passenden Geokoordinaten.

Weitere Kooperationen bei der Datenverarbeitung gab es mit der Fachstelle Archiv des DDB-Teams bei der Aufbereitung und der Automatisierung des Imports von Archivdaten in das Archivportal-D.

Neben Erfolgsgeschichten hatten wir auch Projekte, die wir von Beginn an abgelehnt, verworfen oder nach kurzer Evaluation abgebrochen haben. Hier ein Projekt, welches erst nach einer mehrtätigen Evaluationsphase verworfen wurde. Das Ziel des Projektes war es, über einen Dublettenabgleich zwischen zwei digital vorliegenden Findbüchern mit insgesamt etwa 64.000 verzeichneten Personenakten, Dubletten über im Titel genannte Personendaten automatisch zu identifizieren. Auf den ersten Blick schien das direkt umsetzbar. Es stellte sich jedoch heraus, dass die 30 unterschiedlichen Informationsbestandteile zu Personen- und Ortsdaten von Orten weltweit, in unterschiedlicher Tiefe und Reihenfolge erfasst waren. Der Dublettenabgleich konnte in der erforderlichen Qualität also nicht vollautomatisch durchgeführt werden. Eine Evaluation basierend auf Vor- und Nachnamen ergab, dass der Anteil an (möglichen) Dubletten höchstens bei 10 Prozent lag und damit weitaus geringer war als erwartet, jedoch zu groß um eine manuelle Prüfung durchzuführen. Im Nachhinein wäre es sinnvoller gewesen, die Prüfung auf mögliche Dubletten zuerst durchzuführen und sich dadurch die langwierige Arbeit mit den vielen Informationsbestandteilen zu den einzelnen Personen zu sparen.

FAIR-Prinzipien für die Datenbereitstellung

Das FDMLab arbeitete nicht nur an der Generierung und Analyse von Daten, sondern evaluierte auch die bisherige Praxis des Landesarchivs bei der Datenbereitstellung über das Online-Findmittelsystem (OLF). Richtschnur waren dabei die sogenannten FAIR-Prinzipien für die Datenbereitstellung, die in der Forschungsdatenmanagementcommunity inzwischen eine weite Verbreitung gefunden haben. Die Abkürzung “FAIR” setzt sich zusammen aus den englischen Adjektiven findable (auffindbar), accessible (zugänglich), interoperable (interoperabel) und reusable (nachnutzbar). Diese Eigenschaften sollten Daten bzw. die Datenbereitstellung besitzen, um eine nachhaltige (wissenschaftliche) Nutzung zu gewährleisten.8

].](/post/2022-07-ein-rueckblick-auf-zwei-jahre-fdmlab/fair_data_principles_hu4960df34c0cdf9a6c6ba50e723c5ac83_41875_bacb4382dd9c913bdf74ed166cfb8593.webp)

Die Untersuchung ergab, dass das Online-Findmittelsystem einige der 15 FAIR-Kriterien bereits erfüllt, sie jedoch noch nicht in vollem Umfang umsetzt. Bei der anstehenden Neuentwicklung eines archivischen Fachinformationssystems, welches künftig auch das jetzige Online-Findmittelsystem ablösen wird, sollen die FAIR-Prinzipien vollständig berücksichtigt werden. Das FDMLab lieferte hier Impulse für die Definition von Anforderungen an das neue AFIS. Die Präsentationskomponente des neuen AFIS soll archivische Daten unter transparenten und leicht verständlichen Nutzungsbedingungen bereitstellen – und dies so offen wie möglich. Dabei gilt es selbstverständlich auf der anderen Seite auch, den Datenschutz, das Urheberrecht und andere Schutzrechte zu wahren.

Eine der bei der Evaluation definierten Anforderungen ist die Einführung eines global eindeutigen Persistent Identifiers (PID), der sowohl die Daten als auch die Metadaten des Landesarchivs weltweit und zeitlich unbegrenzt kennzeichnet und somit eine sichere Zitation ermöglicht.

Die rechtlichen Nutzungsbedingungen sollen über die derzeitige zentrale Infoseite auf der Homepage des Landesarchivs hinaus auch auf den Detailseiten der einzelnen digitalen Objekte verlinkt werden. Dadurch soll es noch einfacher werden, sich über Lizenzen etc. zu informieren.9

Außerdem soll das neue AFIS eine frei zugängliche Schnittstelle besitzen, über die Daten in einem maschinenlesbaren Format und in flexiblem Umfang (einzelne Digitalisate oder Batch-Verarbeitung) zum Download bereitstehen. Dies wäre dann eine ergänzende Möglichkeit zum Download, zusätzlich zu den bereits heute verfügbaren Downloadmöglichkeiten über die DDB bzw. das Archivportal-D.

Weiter wurden die Voraussetzungen zur Verwendung eines IIIF-kompatiblen Viewers untersucht. Um Metadaten auch in einem semantischen Datenmodell anzubieten, soll im neuen AFIS der neue archivische Erschließungsstandard Records in Context (RiC) des International Council on Archives (ICA) genutzt werden.

Konferenzen und Veranstaltungen

Neben unserer praktischen Tätigkeit waren wir als FDMLab auch auf einigen Veranstaltungen, wie dem Südwestdeutschen Archivtag und der Konferenz “Offene Archive” sowohl als Teilnehmende, als auch zur fachlichen und technischen Unterstützung oder als Vortragende aktiv. Eine Liste von Vorträgen und Präsentationen des FDMLab haben wir auf unserer Webseite unter dem Menüpunkt Vorträge veröffentlicht.

Im Bereich Forschungsdatenmanagement waren wir während unserer ersten Projektlaufzeit eher in der Orientierungs- und Planungsphase und haben die tatsächliche Implementierung und Umsetzung in Form von Vorarbeiten an andere Projekte innerhalb des Landesarchives weitergegeben.

Eine abwechslungsreiche Ausnahme unserer Tätigkeiten war die Unterstützung von Datenberaterinnen und Datenberatern für Archive in Baden-Württemberg für den Kultur-Hackathon Coding da Vinci Baden-Württemberg 2022.

Ausblick

Das FDMLab hat sich in seiner ersten Projektlaufzeit mit verschiedenen Themen beschäftigt, die für Archive noch weitestgehend Neuland sind. Bei der automatischen Erstellung von Volltexten und der Datenanalyse und –anreicherung mit Hilfe verschiedener Tools und Technologien konnte wertvolles Wissen und bei vielen praktischen Projekten Erfahrungen gesammelt werden. Dennoch bleibt auch weiterhin viel zu tun: Ergebnisse aus Experimenten und Prototypen sollen in den Produktivbetrieb überführt werden, Volltexte und angereicherte Metadaten in größerem Umfang generiert werden. Und so freuen wir uns außerordentlich, dass das Projekt FDMLab@LABW nach der ersten Projektlaufzeit verlängert wird und wir mit der Unterstützung des Ministeriums für Wissenschaft, Forschung und Kunst Baden-Württemberg ein weiteres Jahr von August 2022 bis Juli 2023 das Thema Maschinelles Lernen im Archiv vorantreiben dürfen.

Eine Übersicht über die im FDMLab getesteten Tools finden Sie unter Werkzeuge zur Texterkennung: ein Blick in die digitale Werkstatt des FDMLab am Landesarchiv Baden-Württemberg und unter OCR im Archiv – ein Blick in das FDMLab@LABW. ↩︎

GLAK 465 c Nr. 418, NS Überlieferung in staatlichen Archiven. ↩︎

C. Clausner, S. Pletschacher, A. Antonacopoulos , “Flexible character accuracy measure for reading-order-independent evaluation”, Pattern Recognition Letters, Volume 131, March 2020, Pages 390-397, https://doi.org/10.1016/j.patrec.2020.02.003 ↩︎

Theoretisch ist es möglich die vom Scanstift gescannten Bilder in einen Zielordner zu speichern und dann automatisiert zum Beispiel mit einem OCR-D Workflow weiter zu verarbeiten. Das setzt jedoch ein recht tieferes technisches Grundverständnis voraus. ↩︎

Dep. 30/1 T1 Fürstlich Thurn und Taxissches Archiv Obermarchtal Grafschaft Friedberg-Scheer. Urkundenregesten 1304-1802. Bearb. Von Robert Kretzschmar. Stuttgart 1993 (Inventare der nichtstaatlichen Archive in Baden-Württemberg ; Bd. 18), Online-Version des gedruckten Inventars. ↩︎

Akten des Reichskammergerichts im Hauptstaatsarchiv Stuttgart: Inventar des Bestands C. Bearb. von A. Brunotte, R.J. Weber, Veröffentlichungen der Staatlichen Archivverwaltung Baden-Württemberg, Band 46 Nr.1-8, Stuttgart 1993-2008. Außerdem: Akten des Reichskammergerichts im Staatsarchiv Sigmaringen: Inventar des Bestands R 7. Bearb. von R.J. Weber, Veröffentlichungen der Staatlichen Archivverwaltung Baden-Württemberg; Band 57, Stuttgart 2004. ↩︎

Bestände GLAK 456 C Nr. 2656-2661, GLAK 456 C Nr. 2664 und GLAK 456 D Nr. 226-228 ↩︎

“FAIR data principles” von SangyaPundir ist lizenziert unter einer CC BY-SA 4.0 Lizenz. ↩︎

Die Metadaten des Landesarchivs stehen unter der Creative Commons-Lizenz CC0. Die Digitalisate werden, wenn dem aus rechtlicher Sicht nichts entgegensteht und sie nicht sowieso gemeinfrei sind, unter der Creative Commons-Lizenz CC-BY weitergegeben. Siehe dazu die Nutzungsbedingungen auf einen Blick. ↩︎